Американські дослідники створили прототип системи, яка зчитує беззвучну мову за допомогою електродів на обличчі і шиї і перетворює її на чутну мову за допомогою нейромережі. Потенційно це дозволяє створити Bluetooth-гарнітуру, що дозволяє розмовляти по телефону, не видаючи звуків, або штучний голосовий апарат для людей з травмами гортані. Автори представили розробку на конференції EMNLP 2020 і отримали нагороду за кращу статтю.

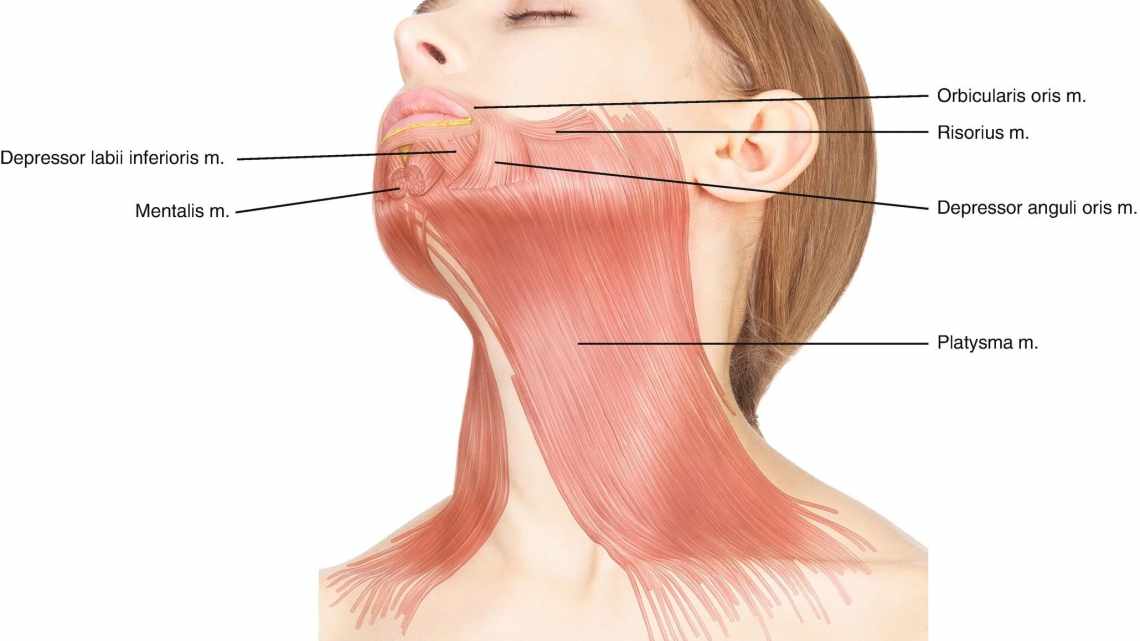

При читанні ми зазвичай не просто бачимо слова і розуміємо їх суть, але і проговорюємо їх про себе, не видаючи при цьому ніяких звуків. Цей процес називається субвокалізацією. Особливість субвокалізації полягає в тому, що, хоча ми і не вимовляємо слова вголос, мозок все одно змушує м'язи голосового тракту рухатися, нехай і набагато менше, ніж при звичайній вокалізованій промові. Інженери досить давно навчилися використовувати ці скорочення мищц і зчитувати їх за допомогою різних методів, в основному за допомогою електроміографії, яка реєструє електричну активність м'язів.

Переважно нейромишкові інтерфейси для розпізнавання субковалізації використовують для перетворення беззвучної мови в текст. Девід Гедді (David Gaddy) і Ден Кляйн (Dan Klein) з Каліфорнійського університету в Берклі створили алгоритм для перетворення беззвучної промови на чутну. Раніше інші дослідники вже вирішували це завдання: на людині закріплювали електроди і він вимовляв текст, а паралельно з цим дослідники записували звук і електричну активність. Потім вони навчали алгоритм на парах звук-електрична активність, що дозволяло відновити перше з другого. Цей підхід спочатку закладає в результати неточність, тому що електрична активність м'язів голосового апарату при чутій і нечуваній промові схожа, але не ідентична.

У новій роботі Гедді і Кляйн використовували більш точний підхід і вирішили навчати алгоритм на всіх трьох типах даних: запис чутного мовлення і активність м'язів під час чути і нечуваної мови. В основі їхнього методу лежить перетворення вихідних сигналів (звуку та електроміографії) на представлення в просторі ознак. Створити перетворювач з простору ознак на сигнал для даних, отриманих при чутій мові, відносно легко, тому що обидва сигнали узгоджені за часом і їх можна використовувати як пари для навчання. Для беззвучної мови це зробити не так легко, тому що парою для електроміографічного сигналу буде беззвучний запис.

Розробники вирішили цю проблему, створивши алгоритм, який приймає всі три сигнали (дві електроміограми і чути мову). На першому етапі він за допомогою алгоритму динамічної трансформації часової шкали знаходить оптимальну відповідність між двома сигналами: іншими словами, він дозволяє взяти фрагмент з першої послідовності і знайти його в другій. На другому етапі алгоритм, використовуючи отриману відповідність, створює з аудіозапису чутного мовлення аудіозапис мови з електроміограми нечуваної.

Цей алгоритм потрібен не сам по собі, а в якості вчителя для нейромережі, яка робить те ж саме, отримуючи на вхід не три види сигналу, а всього один (електроміограму нечуваної мови). Дослідники використовували рекуррентну нейромережу з довгою короткостроковою пам'яттю (LSTM). Потім дані з простору ознак, отримані на виході з нейромережі, подаються на нейромережу WaveNet, що декодує їх в аудіозапис людського голосу.

Дослідники зібрали власний датасет для навчання алгоритму. Він складається з 20 годин запису чутного і беззвучного мовлення одного добровольця, представленого у вигляді трьох типів даних (звук-дві електроміограми). Навчивши нейромережу, автори перевірили зрозумілість генерованих записів мови. Зазвичай при перевірці нових алгоритмів їх результати порівнюють з результатом кращого на даний момент алгоритму для цього завдання (state of art). Оскільки раніше ніхто безпосередньо не переносив промову з електроміограми беззвучної мови в звук, автори вирішили порівняти повноцінну нейромережу з нею ж, але навченої на даних з електроміограми чутної мови.

Тести проходили на закритому словнику (людина зачитувала прості фрази типу дати) і на відкритому (уривки з книг). Як метрику автори використовували стандартну присловну ймовірність помилки (WER): сума змінених, відсутніх і зайвих слів, поділена на загальну довжину тексту. На закритому словнику ймовірність помилки для повноцінної нейромережі склала 3,6, а для тієї, яку навчали тільки на чутній промові, вона склала 88,8. На відкритому словнику різниця була не такою великою: 74,8 до 95,1 при перевірці людиною і 68 до 91,2 при перевірці системою розпізнавання мовлення Mozilla DeepSpeech.

Дослідники опублікували код алгоритмів і датасет на GitHub. Крім того, на сайті конференції опубліковано доповідь одного з авторів, в якому, крім іншого, можна почути результати роботи нейромережі (наприкінці ролика).

Сучасні алгоритми вміють розпізнавати й іншу нечутну мову. Наприклад, минулого року китайські та американські інженери навчили нейромережу читати промову по губах.